- 0

- 0

Optimizing LLM Interactions for Superior Results

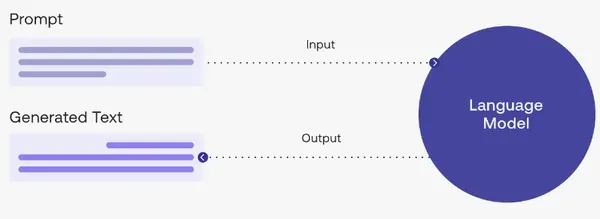

Large Language Models (LLMs) like Bard have revolutionized how we interact with technology, offering incredible potential for content creation, translation, and problem-solving. However, harnessing their full power requires effective communication. This is where RRR Prompting shines, a strategic approach that elevates your LLM interactions from basic instructions to sophisticated dialogues.

Understanding the Basics: Prompting and Prompt Engineering

At its core, prompting involves providing LLMs with instructions, like questions or writing prompts, to guide their outputs. Prompt Engineering takes this a step further by strategically crafting prompts to achieve specific results. This requires a deep understanding of LLM capabilities and limitations, employing techniques like:

- Including relevant examples and data: Providing context helps LLMs understand the desired output style and content.

- Specifying desired output formats: Whether you want a poem, code, or script, clearly stating the format ensures aligned results.

- Using specific keywords: Guiding the LLM with relevant keywords helps focus its attention and generate more accurate responses.

Exploring Different Types of Prompting

Prompts come in various flavors, categorized by function, modality, and specificity:

- Function:

- Response prompts: Aim for specific responses like answers or creative text formats.

- Stimulus prompts: Provide context for tasks such as summarization or translation.

- Modality:

- Verbal prompts: The most common type, using written or spoken instructions.

- Visual prompts: Employ images for tasks like captioning or story generation.

- Auditory prompts: Utilize sounds for music generation or speech recognition.

- Specificity:

- Open-ended prompts: Allow LLMs creative freedom within a general topic.

- Closed-ended prompts: Offer specific instructions for focused responses.

- Additional Prompts:

- Continuation prompts: Build upon existing text for tasks like dialogue or story writing.

Introducing RRR Prompting: A Game Changer

Developed by AI expert Raju Kandaswamy, RRR Prompting offers a structured approach to optimize LLM interactions. It stands for:

- Role: Define a specific role for the LLM, setting the context for its responses. For instance, “You are an expert Python developer with 20 years of experience.”

- Rule: Establish a set of instructions or limitations for the LLM to follow. Examples include adhering to clean code practices or specific design principles.

- Response: Specify the desired output format and content, ensuring alignment with your goals.

RRR in Action: A Practical Example

Imagine you want the LLM to generate Python code for a bubble sort algorithm suitable for production use.

Without RRR:

“Write Python code for bubble sort.” This basic prompt lacks context and direction, potentially leading to suboptimal results.

With RRR:

- Role: You are a senior Python developer with extensive experience in writing production-level code.

- Rule: Adhere to clean code principles and ensure the code is efficient and well-documented.

- Response: Generate Python code for a bubble sort algorithm in JSON format.

By providing a clear role, rules, and desired response, RRR prompting ensures the LLM generates high-quality, contextually relevant code that meets your exact requirements.

Unlocking the Power of LLMs

RRR prompting empowers users to interact with LLMs more effectively, leading to superior results in various applications. Whether you’re a developer, writer, or simply exploring the potential of AI, incorporating RRR into your workflow can significantly enhance your LLM experience.

Leave a Reply